Les géants américains de l’intelligence artificielle (IA), sollicités par le gouvernement Trump, l’encouragent à poursuivre la dérégulation de l’IA, donnant le la au monde entier dans un contexte ultra-concurrentiel. Dès sa prise de fonctions, le nouveau président américain a annulé un décret pris par son prédécesseur qui imposait aux entreprises du secteur de communiquer leurs données lorsque leurs programmes présentaient des «risques sérieux».

Donald Trump a aussi enjoint toutes les agences publiques fédérales de ne plus suivre les recommandations de bonnes pratiques introduites par Joe Biden. «Le président Trump a fait une priorité du positionnement des États-Unis aux avant-postes de l’IA», précise l’un des décrets pris fin janvier.

Ces textes ne font pas mention des risques associés à l’IA, telles les menaces que peuvent présenter les interfaces d’intelligence artificielle générative en cas de détournement ou de perte de contrôle. «On ne gagnera pas dans l’IA de demain si on se fait des noeuds au cerveau avec la sécurité», a martelé le vice-président JD Vance lors du sommet de l’IA à Paris.

Ce revirement résonne bien au-delà des États-Unis. «On va voir un ralentissement marqué des initiatives en matière de régulation, dans le monde entier», annonce David Danks, professeur d’analyse de données et de philosophie à l’université de Californie à San Diego. «On le voit même en Europe», dit-il, où l’accent est davantage mis sur l’accompagnement de l’IA et les investissements que sur les contraintes imposées par l’Union européenne avec son règlement IA Act, en application depuis août.

La Commission européenne a décidé, en février, de reporter sine die les discussions sur une nouvelle directive qui instaurerait un régime de responsabilité pour les dommages éventuels causés par l’IA. «On s’éloigne clairement de l’idée d’une approche cohérente et globale de la régulation de l’IA», abonde Karen Silverman, du cabinet de conseil Cantellus Group.

«Course contre la Chine»

Le gouvernement Trump a lancé un appel à contributions sur le sujet, dans lequel se sont engouffrés promptement les grands acteurs de l’IA, en premier lieu OpenAI. Tout comme le chef de l’État, la start-up fait de l’IA un enjeu de souveraineté, pour «empêcher d’abandonner à la Chine notre position de leader».

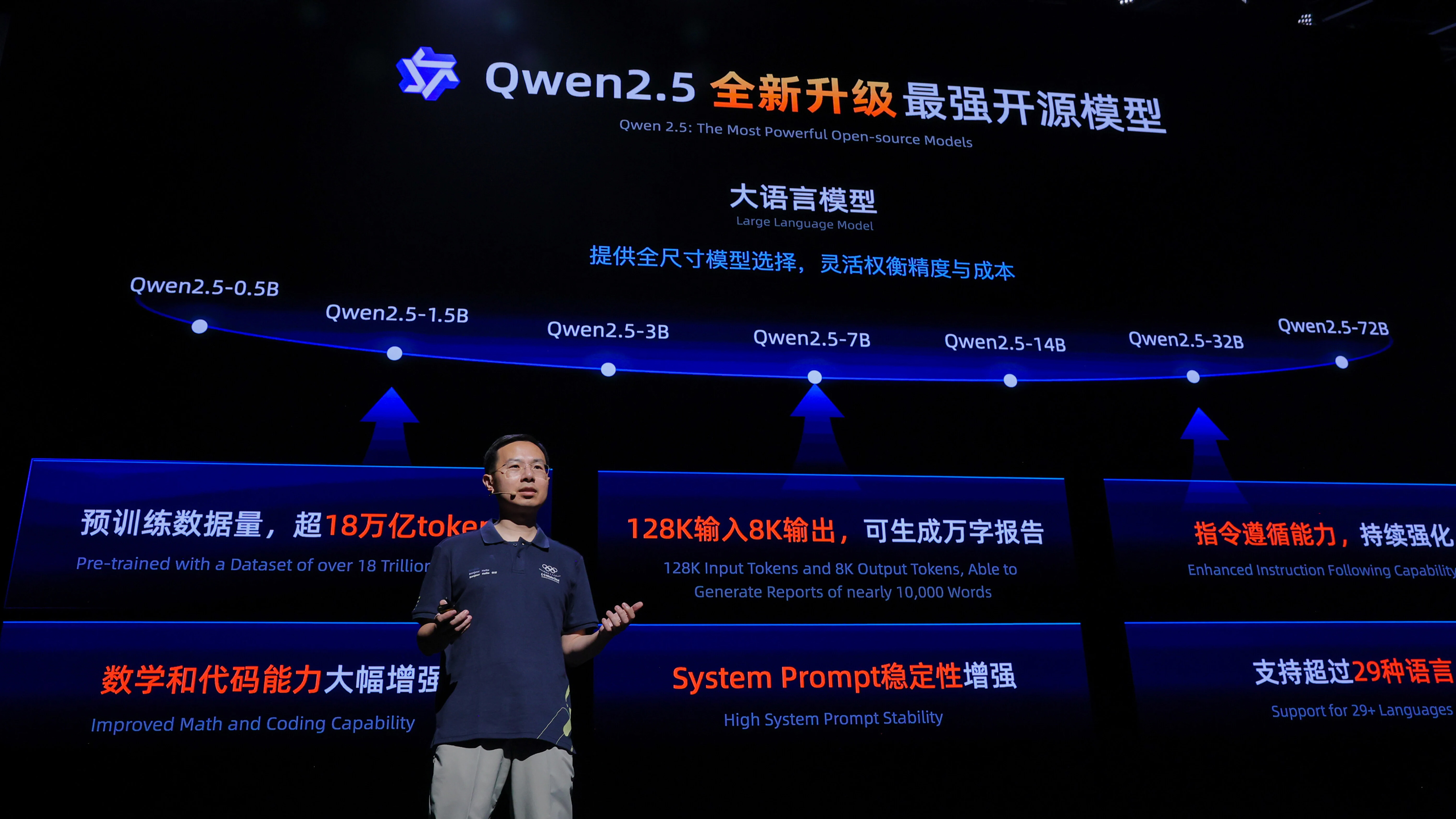

La montée en puissance de la Chine sur ce créneau a été illustrée par l’arrivée de la start-up chinoise DeepSeek et son interface R1. Selon OpenAI, l’intelligence artificielle «made in America» devrait être «protégée (…) des couches de réglementation et de bureaucratie» et «avoir à se conformer à des législations excessivement lourdes des États» ferait le jeu des Chinois.

OpenAI suggère aussi aux autorités américaines d’assouplir les règles d’utilisation de contenu soumis au droit de la propriété intellectuelle pour développer les modèles d’IA générative tels ChatGPT ou Gemini de Google. «Sans accès raisonné» à ce matériau, «les États-Unis seront perdants, tout comme l’IA démocratique», prétend l’entreprise dirigée par Sam Altman, alors que de nombreux artistes ont saisi la justice pour faire valoir leurs droits face à l’utilisation indue de leur production.

Meta a aussi mis en avant «la course contre la Chine» et la nécessité de «s’assurer de la domination de l’IA américaine». Se voulant rassurants, la plupart des grands noms de cette technologie émergente assurent avoir mis en place, en interne, de puissants garde-fous, à même d’éviter qu’un modèle ne dérape ou soit utilisé de façon nocive.

Pour David Danks, les vedettes de l’IA redoutent «la mauvaise presse», «et si votre technologie entraîne des catastrophes, l’opinion publique va vous tomber dessus». Pour autant, si l’auto-régulation peut produire des résultats, reconnaît l’universitaire, «elle n’inclut pas les retours extérieurs, qui sont vraiment très importants».